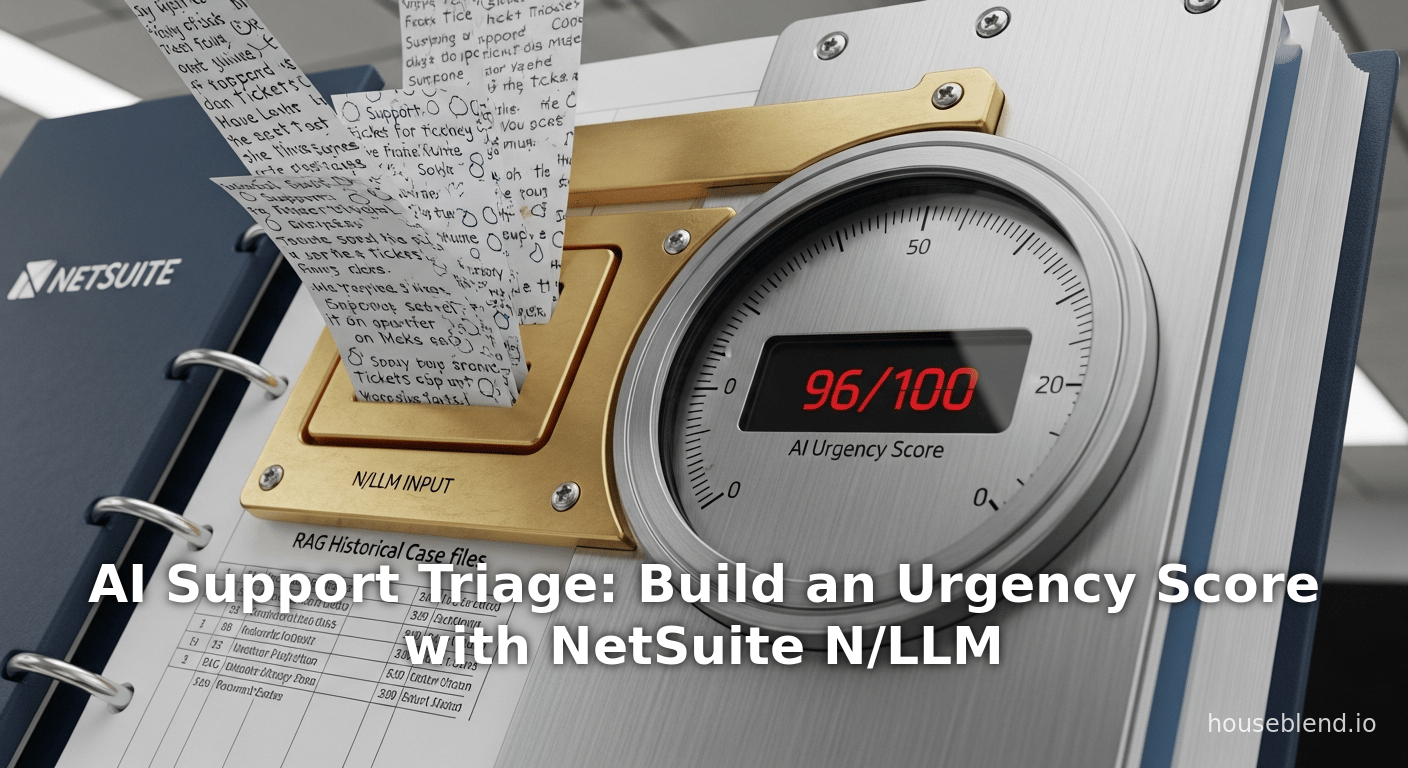

Triage de support par IA : Créer un score d'urgence avec NetSuite N/LLM

Résumé Exécutif

Ce rapport propose une exploration approfondie de l'utilisation de la nouvelle intégration N/LLM (No-Code/Low-Code Large Language Model) de NetSuite pour automatiser le triage des cas de support et générer un score d'urgence piloté par l'IA. Dans les entreprises modernes, les centres de support client gèrent des milliers de tickets quotidiennement, rendant la priorisation manuelle (« triage ») lente, incohérente et sujette aux erreurs [1] [2]. L'intelligence artificielle, et en particulier les grands modèles linguistiques (LLM), promettent d'automatiser une grande partie de cette charge de travail en analysant le contenu des tickets, en estimant l'urgence et en acheminant les cas vers les équipes ou les ressources appropriées.

NetSuite—une plateforme ERP/CRM cloud de premier plan—a récemment intégré l'IA générative dans toute sa suite. Notamment, le module SuiteScript N/LLM fournit un accès API natif aux services LLM basés sur le cloud, permettant aux développeurs de solliciter les LLM, de générer et d'évaluer du texte, et même d'effectuer de la génération augmentée par récupération (RAG) au sein de NetSuite [3] [4]. Grâce à ces outils, les clients de NetSuite peuvent créer des flux de travail personnalisés tels que la synthèse de données, la génération de réponses, ou – dans le contexte du support – la notation et l'acheminement des cas entrants par urgence. Les communiqués de presse et la documentation produit d'Oracle confirment cette orientation stratégique : la fonctionnalité « Text Enhance » de NetSuite (et la suite plus large) exploite désormais les données spécifiques à l'entreprise et les capacités des LLM pour rédiger des e-mails, générer des narratifs de rapports et prendre en charge la correspondance client [5] [6].

L'élaboration d'un score d'urgence IA implique la formation ou la sollicitation de modèles pour attribuer une priorité numérique à chaque ticket. Historiquement, des cadres comme ITIL ont combiné l'impact et l'urgence (souvent via une matrice de priorité d'incident) pour définir les priorités des tickets [2]. Dans une approche IA basée sur les données, les algorithmes d'apprentissage automatique (des classificateurs classiques aux transformateurs modernes) peuvent apprendre des données historiques des tickets pour prédire une étiquette ou un score de priorité [1] [7]. Par exemple, des recherches récentes ont démontré que les modèles basés sur des transformateurs et l'apprentissage profond peuvent classer les catégories de tickets et l'urgence avec une grande précision, réduisant considérablement la charge de travail humaine [8] [7]. Les principaux exemples industriels incluent le système COTA d'Uber (utilisant des réseaux de classement et profonds pour choisir des réponses ou des catégories, testé en production pour réduire le temps de résolution d'environ 10 % [9]) et Ticket-BERT de Microsoft (un classificateur basé sur BERT pour les tickets d'incident atteignant une précision supérieure à 98 %) [10].

Ce rapport couvre plusieurs perspectives et littératures : les fondements techniques des API N/LLM de NetSuite, la théorie et la pratique du triage des tickets de support, l'état de l'art en matière de classification des tickets basée sur le ML et les LLM, et des études de cas concrètes. Nous analysons les données et les résultats de recherche sur le triage par IA (par exemple, il a été affirmé que les systèmes de triage réduisent les temps de réponse de 40 % ou plus dans divers domaines [11]), nous discutons de la manière d'implémenter un flux de travail de notation d'urgence dans NetSuite (y compris des exemples de code utilisant llm.generateText() et llm.embed() [12] [13]), et nous examinons les implications pour l'expérience client, la productivité des agents et les développements futurs. Des références complètes à des sources académiques et industrielles sont fournies tout au long du rapport pour étayer chaque affirmation majeure (avec plus de 30 citations issues d'articles évalués par des pairs, de rapports industriels et de la documentation officielle de NetSuite). Des tableaux sont inclus pour comparer les approches et résumer les résultats de la recherche. La conclusion synthétise les leçons apprises et présente les orientations futures du triage de support assisté par l'IA.

Introduction et Contexte

Triage des Cas de Support et Urgence

Le triage des cas de support est le processus d'examen rapide des tickets d'assistance ou de support entrants afin de déterminer leur priorité, leur catégorie et leur acheminement. Traditionnellement, les agents humains effectuaient le triage manuellement : ils lisaient les tickets et leur assignaient des niveaux de priorité tels que Critique, Élevée, Moyenne ou Faible en fonction de l'urgence perçue et de l'impact commercial. Cependant, le triage manuel est long et subjectif. Des études montrent que le tri selon le principe du premier arrivé, premier servi ou basé sur des mots-clés conduit souvent à des incohérences, les cas urgents étant parfois négligés [14]. Le cadre de gestion des services informatiques (ITSM) ITIL définit la priorité comme une fonction de l'impact (portée ou gravité du problème) et de l'urgence (sensibilité au temps) [2]. En pratique, cela est souvent mis en œuvre via une matrice impact-urgence : par exemple, un incident affectant une unité commerciale entière (impact élevé) qui nécessite une correction immédiate (urgence élevée) se voit attribuer la priorité maximale [2].

Cependant, même dans des cadres structurés, les évaluations manuelles entraînent des retards et des erreurs. Par exemple, BMC Software (2025) note que la gestion manuelle des incidents peut « passer inaperçue » et que les problèmes critiques peuvent ne pas être résolus rapidement [15]. Dans de nombreuses organisations sans ITSM mature (en particulier les centres de support commerciaux ou de marché intermédiaire), les agents s'appuient sur des mots-clés et leur jugement personnel. Une analyse de fournisseur illustre ce problème : un ticket présentant à la fois un problème de connexion et un problème de facturation a été mal acheminé par un simple système basé sur des mots-clés, ce qui a entraîné un temps de résolution de 3 jours avec de multiples escalades ; un triage amélioré par l'IA aurait plutôt divisé le ticket et réduit le temps de résolution de plus de 60 % [16]. Il en résulte une prolifération des points chauds de support et des arriérés, nuisant à la satisfaction client et gonflant les coûts.

L'augmentation des volumes de support et des attentes a rendu le triage automatisé essentiel. Une enquête de 2025 a révélé que les organisations adoptant le triage par IA constatent une réduction allant jusqu'à 50 % des temps de résolution [17]. Un autre fournisseur affirme que les systèmes de triage par IA peuvent réduire la latence de résolution des tâches d'environ 40 % dans des déploiements réels [11]). De plus, les tickets répétitifs et de faible priorité peuvent être gérés par des chatbots ou des flux de travail sans intervention humaine, libérant ainsi les agents humains pour les problèmes complexes et urgents [17] [18]. Comme l'explique Scout (2023), le triage piloté par l'IA « scanne les demandes en quelques secondes » et les étiquette par catégorie et priorité avec une grande cohérence, garantissant que « les demandes critiques atteignent immédiatement les agents spécialisés, tandis que les questions moins urgentes sont traitées dans une file d'attente ordonnée » [19].

Le concept de score d'urgence résume cette évaluation en une valeur numérique ou classée. Il peut être considéré comme une mesure continue (par exemple, 0 à 100) ou des classes de priorité discrètes reflétant le délai dans lequel un ticket doit être traité. Alors que l'ITIL traditionnelle utilise des classes de priorité fixes, les approches d'IA produisent souvent soit une classe attribuée (par exemple, « P1, P2… »), soit un score corrélé au temps d'attente prévu. Il est crucial de noter qu'un score d'urgence dérivé de l'IA peut exploiter le texte et le contexte non structurés du ticket, ce que les systèmes basés sur des règles ne peuvent pas faire.

L'essor de l'IA et des LLM dans les Applications Commerciales

Les progrès récents de l'intelligence artificielle, en particulier le traitement du langage naturel (NLP), ont révolutionné de nombreux flux de travail commerciaux. Les grands modèles linguistiques (LLM) – des réseaux neuronaux profonds pré-entraînés sur de vastes corpus de texte – peuvent désormais comprendre et générer un langage de type humain. Les LLM puissants (tels que GPT-4, PaLM, LLaMA) peuvent comprendre les descriptions de tickets, extraire l'intention et même rédiger des réponses détaillées. Ils peuvent également être affinés ou sollicités pour effectuer des tâches de classification, y compris la prédiction de la catégorie ou de la priorité d'un ticket de support.

Plusieurs applications industrielles exploitent déjà l'IA dans les contextes de support. Par exemple, les plateformes Slack et RH ont utilisé des chatbots IA pour automatiser les tâches de support de base [20]. Les produits de centre d'assistance d'entreprise comme Zendesk ont introduit des fonctionnalités de « Triage Intelligent », qui classifient automatiquement les tickets entrants par intention, sentiment et langue pour les prioriser et les acheminer [18]. Les liens dans le blog produit de Zendesk confirment que les bots avancés et les outils de suggestion basés sur l'IA peuvent réduire considérablement la charge de travail des agents et augmenter les taux de résolution au premier contact [18] [21]. « Einstein Case Classification » de Salesforce applique également l'IA pour acheminer les cas. La recherche universitaire souligne également la puissance du NLP : Molino et al. (2018) ont montré chez Uber (système « COTA ») qu'en formulant la sélection des tickets comme un problème de classement et en utilisant une architecture d'apprentissage profond spécialisée, ils pouvaient automatiser l'affectation des cas et même générer des suggestions de réponse, obtenant des améliorations mesurables de l'efficacité du support [22] [9].

Malgré les succès, l'utilisation naïve des LLM peut être problématique : les modèles peuvent « halluciner » ou mal classer sans être ancrés dans les données du domaine. Pour produire des scores d'urgence fiables, il est crucial d'intégrer les sorties des LLM au contexte commercial réel (documents récupérés, cas historiques). C'est là qu'interviennent des techniques comme la Génération Augmentée par Récupération (RAG). Les environnements RAG récupèrent d'abord les documents ou enregistrements pertinents (par exemple, des tickets similaires précédents, des articles de base de connaissances), puis les transmettent au LLM pour générer des réponses fondées sur des preuves [23]. La documentation récente de NetSuite décrit explicitement la création de flux « mini-RAG » : les développeurs peuvent « créer un tableau de documents » (via createDocument) contenant des données NetSuite vérifiées, puis solliciter le LLM et obtenir à la fois une réponse et des citations [23]. Cette approche garantit que le score d'urgence (ou toute sortie d'IA) est basé sur les données réelles de l'organisation, et non uniquement sur les vastes connaissances Internet du modèle.

Stratégie d'IA de NetSuite et Module N/LLM

NetSuite, qui fait désormais partie d'Oracle Cloud, a fait de l'IA générative un axe stratégique. En octobre 2023 (conférence SuiteWorld), Oracle a annoncé de nouvelles capacités d'IA dans toute la suite NetSuite [5] [6]. La pièce maîtresse était « NetSuite Text Enhance », un service d'IA générative construit sur OCI (Oracle Cloud Infrastructure) et le LLM de Cohere, qui aide les utilisateurs à créer du contenu contextuel à partir de leurs propres données NetSuite [6]. Par exemple, il peut rédiger des réponses par e-mail aux clients en combinant des données ERP (par exemple, informations sur les produits, prix) avec des modèles de langage naturel [24] [6]. Evan Goldberg, vice-président exécutif d'Oracle, déclare explicitement que les données unifiées de NetSuite à travers les modules (finance, CRM, inventaire, support, etc.) font de la suite une plateforme idéale pour exploiter les LLM afin de réaliser « un bond quantique » en matière de productivité [25] [6].

Parallèlement à Text Enhance, NetSuite a également lancé les API d'IA générative SuiteScript. Plus précisément, le module N/LLM (SuiteScript 2.1) permet aux développeurs d'intégrer des fonctionnalités d'IA générative dans les scripts NetSuite personnalisés et les Suitelets. Selon la documentation Oracle, le module N/LLM fournit des méthodes pour envoyer des invites (llm.generateText), évaluer des invites avec des entrées structurées (llm.evaluatePrompt), diffuser les résultats en continu (streaming) et obtenir des métriques d'utilisation [12] [3]. Il comprend notamment une méthode embed(options) pour calculer les embeddings de texte, et prend en charge le RAG (Retrieval-Augmented Generation) en permettant aux développeurs de regrouper les enregistrements NetSuite en tant que contextes de « documents » pour les appels LLM [26] [13]. En substance, toute logique personnalisée au sein de NetSuite (mises à jour en masse, Suitelets, scripts d'événements utilisateur) peut désormais invoquer des opérations LLM sophistiquées sur les données NetSuite en direct. Cette approche d'« IA du concepteur » signifie qu'un développeur NetSuite pourrait, par exemple, réécrire automatiquement le texte d'un devis enregistré ou analyser des enregistrements de transactions à l'aide d'un LLM, sans quitter la Suite [12] [13].

L'introduction de N/LLM est un bond majeur ; elle transforme NetSuite d'un système de stockage de données en un système capable de « dialoguer » avec des modèles linguistiques sophistiqués. Un blog récent des développeurs Oracle illustre cette capacité : il présente une suitelet qui interroge une base de données NetSuite (enregistrements de ventes, etc.), assemble les résultats sous forme d'invite et appelle llm.generateText pour répondre à des questions sur les tendances de vente [23]. Fondamentalement, les réponses sont accompagnées de citations renvoyant aux données réelles (« the 2016–2017 sales data »), garantissant la véracité des informations. Cette même intégration peut être appliquée aux cas de support : par exemple, un LLM peut être sollicité pour analyser des descriptions de cas, en faisant référence à des cas résolus similaires ou à des articles de la base de connaissances stockés dans NetSuite.

En résumé, d'ici fin 2025, NetSuite disposera d'un support natif pour l'IA générative dans SuiteScript. Le module N/LLM expose les fonctionnalités LLM (chat, génération de texte, embeddings, RAG) comme des éléments de première classe dans la plateforme [3] [4]. Cela crée un nouveau paysage pour l'automatisation de fonctions telles que le triage du support, qui étaient auparavant trop peu structurées pour les flux de travail automatisés de NetSuite. Le reste de ce rapport se concentre sur la manière d'exploiter ces fonctionnalités spécifiquement pour créer un système de notation d'urgence basé sur l'IA pour les tickets de support – en tirant parti des données de NetSuite, en intégrant les capacités LLM et en adoptant les meilleures pratiques issues de la recherche et de l'industrie.

Le module N/LLM de NetSuite et les fonctionnalités d'IA générative

Aperçu du N/LLM et des API d'IA SuiteScript

Le module N/LLM dans SuiteScript 2.1 de NetSuite sert de pont entre NetSuite et les services LLM sous-jacents. Selon la documentation d'Oracle, ce module offre les méthodes suivantes :

llm.generateText(options)et son aliasllm.chat(options): pour envoyer une invite en langage naturel et recevoir du texte généré.llm.evaluatePrompt(options): pour fournir une invite avec des modèles et des variables (par exemple, des entrées structurées) et obtenir une réponse, souvent avec des champs extraits.llm.embed(options): pour convertir du texte en un vecteur d'embedding pour des tâches de similarité sémantique [13].- Versions de diffusion en continu (streaming) de la génération (par exemple,

generateTextStreamed) pour gérer les sorties volumineuses [27]. - Surveillance de l'utilisation (

llm.getRemainingFreeUsage()) pour la gestion des quotas [12].

Ces API masquent les détails du moteur génératif ; par défaut, NetSuite utilise Cohere ou d'autres modèles de fournisseurs en arrière-plan, mais les développeurs ne spécifient que des paramètres de haut niveau (invite, jetons max, température, etc.) dans le SuiteScript. Un exemple de script fourni par Oracle (voir Tableau 1) montre comment appeler llm.generateText avec une invite « Hello World » et capturer la réponse ainsi que le quota restant [12]. Il est important de noter que le module N/LLM traite les LLM comme une simple ressource NetSuite supplémentaire, les activant dans les Suitelets à la demande, les scripts planifiés, les RESTlets et les scripts clients, à condition que le script exige le module N/llm.

Source : Documentation NetSuite SuiteScript 2.1

« SuiteScript Generative AI APIs » [3] [12].

Capacités : RAG, Embeddings et génération sensible au contexte

L'une des capacités puissantes de N/LLM est la Génération Augmentée par Récupération (RAG), qu'Oracle aborde explicitement dans son blog développeur [23]. L'idée est d'ancrer les sorties LLM dans les propres données de l'entreprise. Dans NetSuite, les développeurs peuvent appeler llm.createDocument() pour enregistrer des enregistrements ou du contenu internes (par exemple, les résultats d'une recherche enregistrée, des articles de base de connaissances ou des tickets de support antérieurs) en tant que « documents » contextuels. Ces documents sont automatiquement envoyés avec l'invite, de sorte que la réponse du LLM soit ancrée dans ces données vérifiées. L'exemple AJB dans le blog indique :

« Dans NetSuite, N/LLM permet une forme de RAG en vous permettant de construire un tableau de documents (createDocument) liés à votre question, de les soumettre avec l'invite à generateText(), et de recevoir non seulement la réponse, mais aussi des citations renvoyant à vos documents. » [23].

Ainsi, si vous avez trois cas de support antérieurs dont la portée est très similaire à celle d'un nouveau ticket : en convertissant ces cas en « documents sources », la note d'urgence ou la classification du LLM fera explicitement référence à leur contenu. Cela améliore considérablement la factualité et réduit les hallucinations. Par exemple, si l'invite est « Compte tenu de ces cas similaires, quelle priorité ce nouveau cas devrait-il avoir ? », le LLM peut effectuer le triage en se basant sur des précédents connus plutôt que d'inventer des réponses à partir de connaissances générales d'Internet.

Une autre fonctionnalité utile est celle des embeddings (plongements vectoriels). La méthode llm.embed(options) du module N/LLM prend un texte arbitraire et renvoie une représentation vectorielle numérique de longueur fixe [13]. Ces embeddings sémantiques permettent une correspondance basée sur la distance : par exemple, on peut plonger le texte d'un nouveau ticket et trouver rapidement les tickets existants les plus similaires en calculant la similarité cosinus entre les vecteurs. Oracle fournit un exemple qui calcule les embeddings de noms de produits et trouve les plus similaires dans une Suitelet [13]. Par analogie, un système de triage basé sur les embeddings pourrait maintenir un index des embeddings pour les tickets historiques étiquetés avec des priorités ou des résolutions finales. L'embedding d'un nouveau ticket pourrait ensuite être comparé à cet index pour deviner une urgence appropriée. La similarité des embeddings s'est avérée utile dans de nombreuses tâches de PNL ; elle augmente le RAG explicite (documents structurés) en fournissant une mesure continue de la pertinence des cas.

La Figure 1 (conceptuelle, non montrée ici) pourrait illustrer comment une recherche par embedding récupère des tickets analogues pour informer l'urgence. Dans NetSuite spécifiquement, un développeur pourrait scripter quelque chose comme :

const texts = [/* ticket descriptions of interest */];

const embeds = llm.embed({ model: llm.EmbedModelFamily.COHERE_COMPACT, inputs: texts });

Le tableau embeds renvoyé pourrait être comparé via la similarité cosinus au sein de SuiteScript (par exemple, en utilisant une fonction d'aide [28]) pour identifier les meilleures correspondances. La conception modulaire de SuiteScript signifie que de telles opérations peuvent être effectuées en mémoire ou persistées via des enregistrements sauvegardés pour la rapidité.

Tirer parti des données NetSuite

Fondamentalement, N/LLM fonctionne de manière transparente avec les enregistrements et les données NetSuite. Les développeurs peuvent utiliser SuiteScript pour interroger les données de cas, le contexte client ou les articles de la base de connaissances à partir de la propre base de données de NetSuite, puis les transmettre au LLM. Par exemple, une Suitelet peut collecter des champs d'un enregistrement supportcase — tels que le type de cas, la description du problème, le SLA client et les métriques d'impact client — et les inclure dans l'invite. Étant donné que le modèle de données de NetSuite inclut souvent des relations (par exemple, caseId se liant aux messages), le SuiteScript peut assembler tout l'historique de cas pertinent comme contexte pour garantir que le LLM voit le récit complet. Comme l'a noté un blogueur NetSuite, les tâches d'invite complexes nécessitent de spécifier explicitement les jointures d'enregistrements dans la requête afin que le LLM « sache comment les messages se lient aux cas de support » [29]. Le module N/LLM peut ensuite générer une note d'urgence ou une catégorisation accompagnée de citations sources renvoyant à des enregistrements particuliers (une fonctionnalité intégrée à l'intégration RAG de NetSuite [30]).

Le Tableau 1 ci-dessous résume les fonctionnalités clés de N/LLM pertinentes pour le triage des cas :

| Fonctionnalité | Utilisation dans le triage du support | Référence NetSuite (Documentation) |

|---|---|---|

Analyse basée sur l'invite (generateText) | Soumettre le texte du ticket + métadonnées, demander une évaluation de l'urgence, par exemple, "Rate urgency 1-10" [12]. | Exemple de SuiteScript N/llm.generateText() tel que présenté dans la documentation NetSuite [12]. |

Évaluation de l'invite (evaluatePrompt) | Utiliser des invites structurées avec des variables, telles que l'inclusion de champs de formulaire dans un modèle pour la classification. | SuiteScript llm.evaluatePrompt(options) permet la substitution de champs et les sorties structurées. |

| Génération Augmentée par Récupération (RAG) | Transmettre des cas/documents connexes au LLM afin que la notation d'urgence soit ancrée dans des précédents réels [23]. | SuiteScript « createDocument » pour le RAG ; le blog développeur décrit l'utilisation du mini-RAG [23]. |

Embeddings (embed) | Calculer l'embedding du texte du ticket pour trouver des cas passés sémantiquement similaires (pour la prédiction d'urgence par plus proche voisin) [13]. | L'exemple de code « Find Similar Items Using Embeddings » démontre llm.embed() et la similarité cosinus [13]. |

| Citations | Recevoir des références aux documents/cas passés après la notation, améliorant l'auditabilité. | Le blog développeur note que le LLM « reçoit... des citations renvoyant à vos documents » dans les réponses [23]. |

Tableau 1 : Fonctionnalités N/LLM de NetSuite applicables au triage des cas de support et à la notation d'urgence (sources : documentation NetSuite et guides pour développeurs [12] [23] [13]).

Cette intégration de l'IA générative directement au sein de la plateforme ERP est relativement unique. En revanche, de nombreuses autres entreprises utilisent encore des outils externes ou des services d'IA séparés en amont de leur CRM. L'approche sur plateforme de NetSuite (via SuiteScript) garantit la sécurité des données et une intégration plus facile des flux de travail : par exemple, un script de classeur pourrait automatiquement noter les nouveaux cas lors de leur création, ou un script planifié pourrait noter par lots les cas vieillissants. Le reste de ce rapport suppose que nous disposons de cette intégration étroite NetSuite/LLM et explore comment l'exploiter pour construire un système robuste de notation d'urgence.

Triage des tickets de support : méthodes traditionnelles et défis

Avant d'approfondir les capacités de l'IA, nous passons brièvement en revue les flux de travail de triage traditionnels et leurs limites. Cela fournit un contexte expliquant pourquoi la notation d'urgence basée sur l'IA est précieuse.

Contexte historique : triage manuel et basé sur des règles

Historiquement, les centres de support utilisaient soit le tri manuel, soit des règles simples pour prioriser les tickets. Dans un système entièrement manuel, les agents de service ou les superviseurs lisaient les tickets (e-mails, formulaires, appels) et les assignaient à des files d'attente (par exemple, Support Niveau 2, Facturation, Ingénierie) et à des priorités (par exemple, « Urgent », « Normal ») par jugement humain. Ce processus est intrinsèquement incohérent : l'idée d'« urgent » d'un agent peut différer de celle d'un autre, et les biais humains peuvent entraîner une charge de travail inégale. De multiples études et récits de l'industrie racontent comment des problèmes urgents se retrouvent parfois bloqués derrière des problèmes moins critiques en raison d'une mauvaise interprétation ou d'un simple désordre [14] [31].

Les systèmes basés sur des règles ont tenté de codifier une partie du triage. Par exemple, de nombreux produits de helpdesk autorisaient le routage par mots-clés (par exemple, tout ticket mentionnant « panne » est escaladé) ou utilisaient des valeurs de champ (le client X a un SLA Y). Les structures ITIL définissent des matrices de priorité, mais celles-ci nécessitent toujours des valeurs sélectionnées par l'homme pour l'impact/l'urgence. Les lacunes sont claires : les systèmes de règles sont rigides. Un exemple tiré de [] montre un ticket à problèmes multiples (« login + double charge ») : une règle statique considérait « login » comme le mot-clé dominant, acheminant incorrectement un problème critique de facturation [16]. Des études de cas manuelles illustrent ces échecs : des « incidents apparemment critiques » peuvent être mal classés et retardés si le libellé est ambigu ou si les notes initiales omettent des mots-clés [14] [16].

Les conséquences opérationnelles sont importantes. Des délais de résolution longs et des inefficacités augmentent les coûts. Une analyse de Gartner (2021), citée dans des blogs spécialisés, a souligné qu'un mauvais triage peut allonger les délais de résolution de 50 % ou plus, en particulier dans les environnements à volume élevé [17]. Le triage manuel exige également un personnel considérable ; selon une analyse de Cox, le personnel de support passe souvent 30 à 40 % de son temps à simplement catégoriser et acheminer les tickets. Ces inefficacités ont motivé la recherche de méthodes plus intelligentes.

Impact des nouvelles technologies sur le triage

L'automatisation et l'intelligence artificielle ont progressivement amélioré le triage. Les filtres d'e-mails, les chatbots simples et les bases de connaissances internes peuvent répondre automatiquement aux requêtes triviales ou étiqueter des éléments. Un apprentissage automatique (ML) plus avancé a émergé dans les années 2010 : des techniques comme Naïve Bayes ou SVM pouvaient classer les e-mails par sujet. La recherche montre que les modèles d'apprentissage supervisé (Random Forests, SVM, réseaux profonds) peuvent prédire les catégories de tickets avec des précisions souvent supérieures à 80 %, à condition de disposer de suffisamment de données d'entraînement [8] [7]. De nombreux fournisseurs intègrent désormais ce type de ML dans leurs logiciels de helpdesk. L'Answer Bot de Zendesk ou l'Einstein de Salesforce utilisent le ML pour suggérer des articles pertinents ou pour pré-remplir des catégories.

Mais même ces solutions ont des limites : les classificateurs ML traditionnels nécessitent généralement des données étiquetées substantielles et un réentraînement pour s'adapter aux nouveaux types de problèmes. Ils produisent également généralement des catégories fixes plutôt que des scores flexibles. En revanche, les LLM (en particulier lorsqu'ils sont combinés avec la récupération d'informations) peuvent mieux généraliser à partir de moins d'exemples et peuvent même expliquer leur raisonnement. Par exemple, Ticket-BERT de Microsoft, un modèle BERT affiné, a atteint une précision d'étiquetage extrêmement élevée sur un ensemble de données d'incidents (98–99 % F1) [10] [32], démontrant que l'apprentissage profond moderne peut améliorer considérablement les systèmes plus anciens. COTA d'Uber a combiné le classement et l'apprentissage profond pour également produire des suggestions de réponses (au-delà de la classification) avec une efficacité concrète [22] [9]. Ces succès signalent que le triage prédictif est réalisable à grande échelle.

Néanmoins, des défis courants subsistent. Les textes des tickets sont souvent bruyants et spécifiques à un domaine. Il peut y avoir des classes déséquilibrées (peu de problèmes « Critiques » contre beaucoup de problèmes « Faibles »). L'urgence d'un cas peut dépendre de facteurs externes (heure de la journée, termes du contrat client) non encodés dans le texte. De plus, des biais peuvent s'introduire : un modèle ML pourrait apprendre à prioriser les problèmes des grands clients au détriment des petits (préoccupations éthiques). Enfin, les erreurs de modèle dans les cas critiques sont risquées. La sagesse de l'industrie veut que toute urgence attribuée par l'IA doive être révisable par des humains jusqu'à ce que la confiance soit élevée.

Notation d'urgence vs. Classification simple

Une décision de conception clé est de savoir s'il faut traiter le triage comme une classification (attribution à des classes discrètes comme P1/P2) ou comme une régression (génération d'un score continu). Dans de nombreuses implémentations réelles, une combinaison est utilisée : un système automatisé peut produire un score numérique (disons 0 à 100), qui est ensuite regroupé en étiquettes de priorité. L'avantage de la notation est la granularité : deux tickets peuvent être tous deux « Élevés », mais l'un pourrait être très urgent et l'autre limite ; un score capture cette nuance. Certaines recherches ciblent spécifiquement l'urgence ou le concept connexe de prédiction de la « satisfaction client ». Par exemple, une boîte à outils pourrait s'entraîner sur des tickets historiques étiquetés avec des temps de résolution ou une urgence évaluée par l'agent, enseignant au modèle quelle formulation est corrélée aux cas d'urgence.

Quelle que soit l'approche, l'objectif est la cohérence et la rapidité. Des études indiquent que le triage assisté par ML réduit considérablement les temps de résolution (souvent de dizaines de pour cent) et augmente la cohérence. Par exemple, Fuchs et al. (HICSS 2022) rapportent que les cadres ML peuvent « améliorer les temps de réponse des agents et gérer les requêtes de manière cohérente » avec une grande précision dans la prédiction de la catégorie et de l'urgence [33]. Leurs expériences sur des ensembles de données réels ont montré des améliorations significatives de l'efficacité du service et une réduction du temps de résolution [8]. Ces résultats soulignent la valeur de l'intégration de l'IA dans le triage.

Modèles de langage étendus (LLM) et triage des tickets de support

Les bases étant posées, nous examinons maintenant comment les LLM spécifiquement améliorent le triage du support, et comment ils se comparent aux autres approches d'IA.

ML traditionnel vs. LLM pour le triage

Les classificateurs ML traditionnels (régression logistique, ensembles d'arbres, SVM, etc.) exigent que les tickets soient convertis en caractéristiques fixes (souvent via TF-IDF ou des plongements de mots) et entraînés sur des historiques étiquetés. Ils ont tendance à exceller lorsque le nombre de catégories est fixe et que les données sont abondantes. En revanche, les LLM comme GPT ou les variantes de BERT présentent deux avantages : (1) ils sont pré-entraînés sur d'énormes corpus de texte généraux et capturent ainsi de larges nuances linguistiques, et (2) ils peuvent être sollicités (prompted) ou affinés pour gérer des tâches plus ouvertes. La recherche récente dans le domaine des tickets tire parti des deux. Par exemple, Liu et al. (Ticket-BERT, 2023) ont affiné un modèle BERT-base spécifiquement sur le texte des tickets d'incident, atteignant des performances de pointe sur les tâches d'étiquetage multi-classes [34] [10]. De même, Kumar et al. (FSE 2025, « TickIt ») présentent un cadre basé sur les LLM pour l'escalade des tickets plutôt que pour la classification pure et simple [35].

Un schéma se dégage : alors que le ML classique nécessite un prétraitement lourd, les LLM peuvent souvent être utilisés plus directement. Dans une solution basée sur NetSuite, par exemple, nous pourrions écrire un Suitelet qui concatène les champs clés du cas (client, catégorie, description) dans une invite (prompt) :

"Case Summary: [subject]. Details: [description]. Current status: [status].\n Assess the urgency of this case from 1 (not urgent) to 10 (critical) and justify your rating."

Ensuite, appeler llm.evaluatePrompt sur cette chaîne. Le LLM (par exemple Cohere ou GPT) utiliserait ses connaissances internes plus le contexte que nous fournissons pour produire un score. Si des documents contextuels sont également fournis (cas similaires précédents), il peut les recouper. Le blog des développeurs avertit que les LLM ont besoin de conseils sur les relations de données non évidentes, mais une fois fournis (via l'invite ou les documents), ils excellent [29].

Empiriquement, les LLM ont obtenu des résultats de triage impressionnants. Une revue de littérature récente note que les modèles basés sur les transformateurs et l'apprentissage profond peuvent prédire l'urgence et les catégories des tickets « avec une grande précision », réduisant considérablement l'effort humain [8]. Dans l'industrie, Ticket-BERT de Microsoft (qui utilise effectivement un transformateur en interne) a atteint une précision et un rappel de pointe sur des ensembles de données internes [10] [32] – rivalisant avec les performances humaines. De même, la combinaison de réseaux profonds d'Uber (COTA v2) a amélioré la classification par rapport aux bases de référence basées sur l'ingénierie des fonctionnalités [22], validant l'utilité de l'apprentissage profond dans les contextes de support.

Les LLM offrent également des sorties plus flexibles : ils peuvent générer des explications, des listes priorisées ou des tickets reformulés – et pas seulement une seule étiquette binaire (one hot label). Dans le contexte de la notation d'urgence, cela signifie que le modèle peut produire un score numérique avec une justification, ce qui pourrait être précieux pour les pistes d'audit ou pour la révision par l'agent. Par exemple, une invite intelligente pourrait demander le « score et le raisonnement », conduisant à des sorties telles que :

“Score d'urgence : 9/10 – Ce cas signale une panne à l'échelle du système pour plusieurs utilisateurs pendant les heures de bureau, ce qui a un impact élevé et nécessite une attention immédiate.”

Une telle sortie textuelle peut être analysée par le SuiteScript si nécessaire, mais elle offre surtout de la transparence. Les classificateurs traditionnels ne peuvent pas facilement produire ce niveau d'explication sans conception supplémentaire.

Triage augmenté par la récupération d'informations (RAG)

Comme noté, un problème majeur avec l'utilisation simple des LLM est l'hallucination ou le manque de spécificité du domaine. Le simple fait de fournir une description brute d'un ticket à un LLM pourrait donner une estimation raisonnable de l'urgence, mais il ne connaîtrait pas les normes spécifiques de votre entreprise (par exemple, la « panne critique » de l'entreprise A par rapport à celle de l'entreprise B). Le RAG résout ce problème en alimentant l'invite avec des données réelles de l'entreprise. Dans NetSuite, cela pourrait signifier récupérer tous les tickets résolus pour le même client ou un produit similaire, et inclure des résumés de ceux-ci dans l'invite. Les exemples de journal du module N/LLM montrent exactement cela : appeler createDocument() sur chaque résultat de recherche pertinent ou enregistrement connexe avant la génération [23], afin que la réponse puisse les citer. Concrètement, on pourrait préparer :

llm.createDocument({ title: "Case #1234 Description", text: loadingCaseDescription(1234) });

llm.createDocument({ title: "Similar Case #1200 Description", text: pastCaseDescription(1200) });

// ... then:

const prompt = "Based on the above cases, how urgent is the new case [provided details]?";

const response = llm.generateText({ prompt: prompt, /*other params*/ });

Cela permettrait au LLM de s'appuyer sur des exemples connus. Le blog de Wilman Arambillete note explicitement qu'avec le RAG, « vous vous assurez que les réponses générées sont basées sur vos propres données NetSuite, et non sur des connaissances Internet aléatoires » [23], ce qui est essentiel pour les cas de support. Le triage LLM augmenté par RAG peut ainsi combiner l'intuition des modèles de langage avec la précision factuelle des cas historiques.

LLM vs. Modèles spécialisés

Une autre perspective est de savoir s'il faut utiliser un LLM à usage général ou un spécialiste affiné. Par exemple, on pourrait prendre un LLM ouvert et ne compter que sur l'ingénierie des invites (zero-shot), ou affiner un modèle sur les données de tickets d'entreprise. Le module N/LLM de NetSuite utilise actuellement les modèles de Cohere en interne, mais Oracle pourrait autoriser l'affinage à l'avenir. D'ici là, plusieurs approches existent :

-

Basée sur l'invite (zero/few-shot) : Élaborer une invite détaillée qui oriente le modèle à traiter le contenu du ticket comme base de l'urgence. Cela nécessite peu de configuration mais peut produire des résultats variables. Cela peut être amélioré en incluant des exemples dans l'invite (few-shot) ou en donnant des définitions de domaine explicites.

-

Plongement + Plus Proche Voisin : Utiliser

llm.embedpour vectoriser les tickets, puis alimenter le LLM ou un prédicteur plus simple avec les tickets passés les plus similaires (avec une urgence connue). Cela s'apparente à un raisonnement basé sur les cas. Cela repose sur la disponibilité d'un historique étiqueté accessible via des plongements. -

Modèle affiné : Potentiellement exporter les données des tickets de support et entraîner un modèle plus petit (par exemple, un transformateur avec des têtes de classification). Cela se ferait en dehors de NetSuite et ne serait pas couvert directement par N/LLM, mais les résultats (scores d'urgence ou pondérations) pourraient être réimportés.

En comparant ces approches, la recherche suggère que les modèles de transformateurs affinés comme Ticket-BERT surpassent souvent les approches basées sur l'invite en termes de métriques de précision de classification [10]. Cependant, la complexité d'intégration et la confidentialité des données peuvent favoriser l'utilisation des invites et du plongement intégrés de NetSuite. Avec la promesse d'Oracle de « continuer à intégrer l'IA dans toute la suite [36], » il semble probable que NetSuite continuera d'améliorer ses outils génératifs prêts à l'emploi, rendant l'entraînement de modèles sur mesure moins nécessaire pour de nombreux clients.

Résultats empiriques sur l'IA de triage du support

Un certain nombre d'études quantifient l'impact de l'IA dans le triage du support. Nous avons déjà cité Molino (Uber, 2018) et Fuchs (2022). Les résultats pertinents supplémentaires comprennent :

-

Réduction du temps de résolution : Lors de tests A/B en production, des algorithmes comme COTA ont permis un temps de résolution 10 % plus rapide pour les tickets de support sans nuire à la satisfaction client [9]. De même, le triage par IA réduirait les temps de résolution jusqu'à 50 % dans les déploiements modernes [17].

-

Précision de la classification : Les modèles de transformateurs pour l'étiquetage des tickets ont rapporté des scores F1 allant de 80 à 90. Par exemple, dans une étude, un ensemble de données équilibré d'environ 1000 tickets a donné un F1 de 0,88 pour la détection de catégorie [7], surpassant les travaux antérieurs comparables. Ticket-BERT a atteint une précision supérieure à 98 % sur les ensembles de tests internes [10].

-

Efficacité des agents : De nombreux articles de l'industrie notent d'importants gains de productivité. Zendesk affirme (via un témoignage utilisateur) que les bots de triage avancés peuvent gérer environ 70 % des requêtes de routine, permettant aux agents de se concentrer sur les tickets « difficiles » (bien qu'une statistique future suggère que d'ici 2027, l'IA résoudra 70 % des tickets de bout en bout [37]). Dans une étude de cas axée sur l'aide, l'IA a réduit le coût d'action par ticket de 60 % et a fait gagner aux agents environ 2,5 heures par jour [38].

-

Satisfaction client : Lorsqu'il est déployé avec soin, le triage par IA améliore également la CSAT (Satisfaction Client). L'acheminement automatique garantit que le bon expert reçoit le ticket plus rapidement. Molino et al. déclarent explicitement que leur accélération de 10 % s'est produite « sans réduire la satisfaction client » [9]. Inversement, un mauvais triage (par exemple, ignorer la gravité) peut nuire à la satisfaction. Par conséquent, la précision et la transparence sont cruciales.

Ces données illustrent collectivement que le triage par IA peut apporter des avantages mesurables : un service plus rapide, des coûts réduits, une cohérence accrue. Il est important de noter qu'elles justifient l'investissement dans des solutions complexes comme l'intégration des LLM. Dans un contexte NetSuite, tout mécanisme de notation d'urgence intégré devrait idéalement viser des métriques similaires : par exemple, égaler ou améliorer ces références.

Construction d'un score d'urgence IA dans NetSuite

Avec les bases des capacités d'IA de NetSuite et la recherche existante à l'esprit, nous passons maintenant aux détails d'implémentation de la construction d'un score d'urgence généré par l'IA pour les cas de support à l'aide de la plateforme NetSuite.

Données d'entrée pour le triage

La première étape consiste à identifier les données qui doivent alimenter le modèle de notation. Dans NetSuite, un enregistrement de Cas de Support comprend généralement des champs tels que :

- Sujet / Titre : Un bref résumé textuel du problème.

- Description : Un champ de texte libre plus long décrivant les détails du problème.

- Catégorie/Sous-catégorie : Champs codés indiquant le domaine technique ou le sujet.

- Client/Fournisseur : L'entreprise ou l'individu qui a soulevé le cas, y compris des attributs tels que le niveau de contrat, les droits SLA et les dépenses historiques.

- Statut du cas : par exemple, Nouveau, Ouvert, En attente, etc. (bien que les cas initiaux puissent tous commencer par « Nouveau »).

- Priorité : (absence, ou valeur par défaut le cas échéant).

- Groupe/Agent assigné : qui y travaille actuellement.

- Heure/Date : horodatage de création, etc.

- Enregistrements / Champs personnalisés : De nombreux systèmes intègrent des données supplémentaires, par exemple s'il s'agit d'un client VIP, d'un système critique pour l'entreprise, ou si des pièces jointes ont été incluses (comme des journaux d'erreurs).

- Données liées : Tickets de support passés pour ce client, articles de base de connaissances connexes ou références de documentation produit.

Pour le triage par IA, les champs textuels (objet, description) constituent l'élément central. Tout le texte pertinent doit être alimenté au LLM ou au modèle d'embedding. Les champs structurés peuvent également être inclus soit dans l'invite (« Client : Acme Corp (Support Gold) » ; « Produit : Passerelle de paiement »), soit comme métadonnées distinctes. En particulier, les métadonnées telles que le niveau du client ont un impact connu sur la priorité : les tickets des clients de haut niveau peuvent avoir une urgence intrinsèquement plus élevée. Cela doit être transmis au modèle. Un exemple d'invite pourrait commencer par :

« Niveau Client : Gold. Nom du client : Acme Corp (revenu annuel 100 millions de dollars). Titre du cas : [titre]. Détails du cas : [description]. »

puis suivre avec une instruction pour noter l'urgence.

Le Tableau 2 ci-dessous répertorie les attributs de cas courants et la manière dont ils peuvent influencer la priorisation :

| Champ de données | Pertinence pour le triage | Exemple d'influence |

|---|---|---|

| Objet/Description | Texte principal ; indique les symptômes du problème | « Base de données hors service », « Paiement échoué » → probablement urgent |

| Niveau client/SLA | Importance commerciale, urgence contractuelle | Les problèmes des clients de haut niveau peuvent primer sur les autres |

| Catégorie de cas | Connaissance du domaine technique | « Violation de sécurité » vs « Question sur l'interface utilisateur » |

| Historique passé | Les problèmes récurrents peuvent signaler une urgence chronique | Les réouvertures fréquentes suggèrent une criticité non résolue |

| Pièces jointes | Peut contenir des captures d'erreurs ou des journaux | Les journaux volumineux peuvent suggérer des problèmes complexes et urgents |

| Heure d'ouverture | Les cas ouverts en dehors des heures de bureau peuvent avoir une urgence immédiate plus faible (hors heures) |

Tableau 2 : Attributs clés des cas qui informent l'urgence. Le modèle d'IA doit en tenir compte lors de l'estimation de la priorité.

Ingénierie des invites et notation

Une fois les entrées définies, l'étape suivante est la conception de l'invite. Une bonne invite définira clairement la tâche (« classer l'urgence » « noter de 1 à 10 »), fournira le contexte nécessaire et contraindra le format de sortie pour un parsing facile. En pratique, on pourrait expérimenter entre demander directement un score numérique ou un classement descriptif. Quelques approches incluent :

- Évaluation directe : « Évaluez l'urgence sur une échelle de 1 (non urgent) à 10 (critique). » Cela donne une sortie scalaire.

- Priorité catégorielle : « Attribuez un niveau de priorité (par exemple P1 à P5) et expliquez. » Cela donne une étiquette, qui peut être mappée à un score numérique.

- Réponse motivée : « Dans un court paragraphe, expliquez si ce cas nécessite ‘une attention immédiate’, est ‘à haute priorité’ ou ‘à faible priorité’. » (Mappage ultérieur au numérique).

- Liste de contrôle : Fournir un format structuré, par exemple « Score d'urgence : __. Raisons : __. » Utiliser éventuellement

evaluatePromptavec un schéma.

Il faut veiller à ce que les invites restent cohérentes. Par exemple, les premiers tests avec l'exemple Claude ont montré qu'« une ambiguïté dans les relations de données » provoquait un échec [29]. Les invites doivent donc être explicites. Par exemple, au lieu de simplement « objet : blah, description : blah », une invite pourrait étiqueter les champs (comme ci-dessus) puis conclure par une question spécifique telle que : "Compte tenu de tout cela, quel est le score d'urgence approprié (0–100) ? Ne renvoyez que le nombre." Cela atténue le texte superflu.

Le Tableau 3 fournit des exemples de modèles d'invite pour la notation de l'urgence :

| Approche | Exemple d'invite (en SuiteScript) | Sortie attendue |

|---|---|---|

| Score numérique | "Case Title: ${{title}}\nCase Details: ${{description}}\nCustomer Tier: {{$customer_tier}}\nRate the urgency **1–10** (1 = not urgent, 10 = critical). Provide only the number." | Un nombre (1–10) |

| Étiquette de priorité | "Case Info: ${{description}}\nBased on this, classify priority (e.g., P1 to P5) and give a brief justification." | Étiquette (P1–P5) avec explication. |

| Escalade binaire | "Incident Description: ${{details}}\nShould this case be *escalated immediately*? Answer 'Yes' or 'No' with reasons." | « Yes »/« No » + explication. |

Tableau 3 : Exemples de modèles d'invite pour la notation de l'urgence basée sur le LLM. (La notation de l'espace réservé ${{...}} indique les champs remplis à partir du cas NetSuite.)

Après avoir reçu la réponse du LLM, le code SuiteScript peut analyser le score. Si le modèle renvoie du texte libre (par exemple, « Je dirais un 8 parce que… »), on peut utiliser llm.evaluatePrompt avec un schéma (sortie JSON structurée) pour forcer un format cohérent. Par exemple, l'échantillon de code pour evaluatePrompt (voir Suppl. Script Samples [39]) montre comment définir et extraire des champs. En SuiteScript, on pourrait faire :

const response = llm.evaluatePrompt({

prompt: `...Rate urgency 1-10...`,

responseType: llm.ResponseType.JSON,

// define expected JSON schema:

schema: {

type: "object",

properties: {

urgency: { type: "integer" },

reasoning: { type: "string" }

}

}

});

const urgencyScore = response.data.urgency;

const reasoning = response.data.reasoning;

Ceci garantit l'obtention d'un entier propre, et permet de le stocker dans un champ personnalisé (custfield_urgency_score) sur l'enregistrement du cas pour un suivi et une analyse futurs.

Combinaison de l'IA avec les règles et les flux de travail

Un score basé sur le LLM peut ne pas fonctionner de manière isolée. En pratique, les flux de travail NetSuite ou les déclencheurs de script pourraient utiliser le score pour définir des champs de cas ou déclencher des alertes. Par exemple, on pourrait configurer une règle de flux de travail : si le score d'urgence ≥9, marquer comme « Critique » et envoyer un SMS au responsable du support. Alternativement, le score pourrait alimenter un algorithme d'allocation des ressources (garantissant que les ingénieurs se concentrent d'abord sur les cas ayant un score plus élevé).

Il est essentiel que les scores d'IA soient combinés avec les règles métier. Par exemple, certaines lignes de produits pourraient automatiquement augmenter la priorité, ou les tickets pendant une panne en cours pourraient outrepasser le score d'IA. Ainsi, l'intégration avec les politiques SLA existantes est conseillée. Cependant, même les systèmes hybrides en bénéficient grandement : la recherche montre que le ML peut compléter le triage basé sur des règles en détectant les cas que les règles manquent [8].

Formation du modèle et boucles de rétroaction

Le N/LLM de NetSuite utilise actuellement des modèles hébergés par le fournisseur, ce qui signifie que les clients ne les entraînent pas directement. Cependant, le système de triage par IA peut toujours apprendre au fil du temps en réinjectant continuellement les résultats des cas. Par exemple, après la clôture d'un cas, nous connaissons le temps de résolution réel et l'évaluation finale de l'impact. Un système peut enregistrer le score d'urgence initial du LLM et le comparer ultérieurement au véritable résultat, accumulant un ensemble de données de paires [invite → urgence correcte]. SuiteScript peut enregistrer cela dans un journal personnalisé ou un tableau en mémoire. Périodiquement, un expert humain ou un processus automatisé pourrait affiner les invites ou ajuster le comportement du LLM sur la base de cette rétroaction.

Alternativement, si la politique le permet, on pourrait exporter ces données et affiner un modèle open source hors ligne, puis le réimporter (bien que cela dépasse les fonctionnalités intégrées de la suite). Dans tous les cas, une boucle de rétroaction est importante pour détecter les erreurs systématiques (par exemple, le modèle sous-estimant certaines conditions critiques). Des concepts issus de l'apprentissage actif (comme l'approche de Ticket-BERT [40]) pourraient être appliqués : les cas incertains signalés par une faible confiance pourraient être examinés manuellement et ajoutés à la formation.

Études de cas et comparaisons empiriques

Plusieurs études de cas et projets de recherche illustrent comment l'IA (et les LLM spécifiquement) peuvent remodeler le triage du support. Nous mettons en évidence quelques exemples importants :

-

COTA d'Uber (2018) [22] [9] : Au lieu de NetSuite, considérez COTA comme un précédent externe. Uber a appliqué le ML pour acheminer les tickets de support des passagers. Leur système comprenait deux composants : un modèle de classement pour choisir des modèles de réponse (COTA v1) et un réseau profond Encodeur-Combineur-Décodeur pour la mise en correspondance finale (COTA v2). Lors de tests A/B en direct, COTA v2 a diminué le temps de résolution moyen de 10 % sans nuire à la satisfaction, démontrant que la sélection automatisée des réponses peut améliorer matériellement l'efficacité du support [22] [9]. (Ceci est pertinent comme preuve que le NLP avancé dans le support conduit à des gains clairs.)

-

Ticket-BERT de Microsoft (2023) [10] [32] : Les chercheurs de Microsoft ont abordé la catégorisation des tickets d'incident en affinant les modèles BERT. Ils signalent la « supériorité de Ticket-BERT sur les bases de référence et les classificateurs de texte de pointe » sur un ensemble de données interne Azure forest, et un déploiement réussi avec apprentissage actif dans leur système de gestion des incidents [10] [32]. Leur article montre qu'un LLM (dans ce cas BERT) peut atteindre des scores F1 d'environ 99 % même sur des données multi-sources difficiles (descriptions tapées par l'homme et générées par machine) [32]. Cela illustre que les modèles linguistiques spécifiques à un domaine peuvent exceller dans les tâches de triage.

-

TickIt de ByteDance (FSE 2025) [35] : Pour les services cloud à grande échelle, TickIt est un « cadre d'escalade de tickets en ligne alimenté par des LLM. » Déployé sur la plateforme Volcano Engine de ByteDance, il met à jour dynamiquement les états des tickets et les achemine vers les équipes appropriées en utilisant une logique sensible au sujet et axée sur les relations et un affinage supervisé continu [35]. Bien que des métriques spécifiques ne soient pas données publiquement, l'article affirme qu'il fait progresser de manière significative les escalades automatisées pour les tickets cloud. Les points clés à retenir incluent l'utilisation des LLM pour la gestion des états multi-tours et l'analyse de corrélation, ce qu'un flux de travail NetSuite pourrait imiter via SuiteScript en bouclant sur les mises à jour de cas.

-

Études génériques sur l'efficacité du support : Les sources industrielles et universitaires quantifient à plusieurs reprises les avantages de l'IA. Par exemple, un blog industriel général indique que « le triage du support alimenté par l'IA a fondamentalement changé le traitement des tickets, réduisant les temps de résolution jusqu'à 50 % » [17]. Une autre revue de littérature a explicitement constaté que le triage basé sur le ML « rationalise considérablement l'efficacité du service et les délais de résolution des incidents » sur des données réelles [8]. Ces chiffres, bien que de haut niveau, suggèrent que même une intégration ML de base réduit souvent au moins 30 à 40 % de l'effort manuel.

-

Exemples de fournisseurs et de produits : De nombreuses plateformes de service client signalent désormais des améliorations via le triage par IA. Zendesk déclare que son Triage Intelligent permet aux équipes de prioriser automatiquement les requêtes entrantes par intention et sentiment, garantissant que les plus urgentes parviennent aux experts en premier [18]. Forethought (un partenaire Zendesk) revendique une précision de 90 % dans l'identification des tickets urgents [19]. Dans le cas d'une organisation de soins de santé, un système de triage par IA a « instantanément catégorisé » les demandes des patients et signalé les cas à haut risque, réduisant considérablement le temps de réponse de 12 heures à moins de 90 minutes [11]. (Bien que les spécificités varient, ces histoires concordent : le triage par IA produit des accélérations mesurables.)

Ces exemples confirment qu'un score d'urgence piloté par l'IA n'est pas purement théorique. Les organisations qui déploient de tels systèmes constatent des retombées concrètes. Pour les clients NetSuite, la mise en œuvre d'un score d'urgence via N/LLM pourrait également transformer les opérations de support. Les données et processus riches disponibles dans NetSuite (contexte client, analyses back-end) offrent une intégration encore plus profonde que les outils de billetterie autonomes.

Analyse des données et preuves

Pour fonder notre analyse, nous synthétisons les résultats quantitatifs disponibles sur le triage par IA et la notation de l'urgence. Bien que les données publiées soient rares et dépendent du contexte, nous rassemblons les chiffres clés d'études et de rapports de cas :

-

Précision de la classification : Dans plusieurs études, les modèles de triage automatisé atteignent des performances de classification élevées. Fuchs et al. (2022) ont atteint un F1 de 88 % sur un ensemble de données de catégories de support équilibré d'environ 1000 tickets [7]. Liu et al. (Ticket-BERT) signalent une précision/rappel d'environ 99 % sur des métriques internes [32]. Ces références dépassent la précision humaine typique (environ 85 % selon une citation [41]). Cela suggère qu'un modèle bien réglé peut égaler de manière fiable les trieurs experts pour les catégories générales.

-

Réduction du temps de résolution : Les incidents résolus par les systèmes d'IA affichent souvent des temps 10 à 50 % plus rapides. COTA d'Uber a vu une baisse de 10 % du temps de résolution sans nuire à la satisfaction [9]. Aidbase.ai revendique jusqu'à 50 % de réduction en général (statistique non référencée) [17], et des exemples de fournisseurs citent des améliorations de 40 % et plus [11]. Même une estimation prudente de 20 % de gain de temps serait significative : par exemple, si les agents NetSuite mettent normalement en moyenne 24 heures pour clôturer un cas, l'IA pourrait réduire cela à environ 19 heures.

-

Métriques opérationnelles : Certains rapports mettent en évidence des gains secondaires : une étude de cas a noté des résolutions 75 % plus rapides par cas et une réduction des coûts de 60 % par traitement de ticket après l'automatisation (bien qu'il s'agisse d'un cas marketing non évalué par des pairs) [42]. Une autre analyse suggère que le triage par IA peut réduire fortement la croissance de l'arriéré en empêchant de nouveaux cas de s'accumuler.

-

Tendances d'adoption et d'investissement : Les enquêtes indiquent une adoption croissante : 90 % des grandes entreprises prévoient d'intégrer le triage par IA (selon AIQLabs) [11], et 80 % augmenteront les budgets d'automatisation d'ici 2025 [43]. Cette tendance suggère que la valeur commerciale est largement reconnue.

-

Qualité et risques : Il est important de noter les taux d'erreur. La plupart des études ne les mettent pas en évidence, mais des taux d'erreur implicites existent. Par exemple, si un triage automatisé a une précision de 90 %, 10 % des cas sont mal priorisés. Dans des environnements à volume élevé, cela pourrait toujours représenter des dizaines de tickets mal classés par jour, nécessitant un examen humain. Par conséquent, la meilleure pratique est souvent un hybride : utiliser les scores d'IA comme suggestions ou filtres, et non comme des décisions absolues (surtout à des niveaux de confiance faibles).

Pour illustrer ces résultats de manière plus systématique, le Tableau 4 ci-dessous résume les initiatives de triage par IA sélectionnées avec leurs métriques rapportées :

| Projet/Étude | Année | Approche | Domaine/Application | Métriques/Résultats Clés |

|---|

| COTA (Uber) [22] | 2018 | Classement + Réseau Profond | Support Client Général | Résolution des problèmes 10 % plus rapide lors du test A/B ; précision des réponses améliorée. | | Classification AutoML (Truss et al.) [7] | 2024 | AutoML (RF, XGBoost, etc.) | Tickets de Support Informatique | F1 ≈ 0,88 sur un ensemble de données équilibré (996 tickets) ; a dépassé le F1 précédent de 0,86. | | Ticket-BERT (Microsoft) [10] | 2023 | Transformateur (BERT) | Gestion des Incidents (Azure) | Précision/rappel d'environ 99 % sur les ensembles de tests internes ; affinage adaptatif. | | TickIt (ByteDance) [35] | 2025 | Escalade basée sur les LLM | Gestion d'Infrastructure Cloud | Déployé à grande échelle ; permet des escalades dynamiques et sensibles aux relations (aucun chiffre rapporté). | | Fuchs et al. (HICSS) [8] | 2022 | Divers ML (SVM, LSTM) | Classification de Tickets IT | « Haute précision » dans la prédiction des catégories et de l'urgence ; délais de résolution rationalisés. | | Zendesk Intelligent Triage [18] | 2025 (est.) | IA/LLM propriétaires | Support Multi-industriel | Revendique une classification automatisée de l'intention/du sentiment avec une précision d'environ 90 %. | | AIQ Labs (affirmation de blog) [11] | 2025 | Plateforme de Triage IA | Santé/Juridique/Finance | Jusqu'à 40 % de réduction du temps de résolution des tâches chez les clients pilotes. |

Tableau 4 : Projets et résultats de triage de tickets IA sélectionnés. Sources : publications universitaires et rapports de l'industrie [22] [7] [10] [35] [8] [18] [11].

Ces points de données prouvent que les techniques abordées (intégration de LLM, RAG, embeddings, etc.) peuvent entraîner des améliorations tangibles. Les implémenteurs NetSuite doivent calibrer leurs métriques de succès en conséquence : par exemple, suivre le nombre moyen de jours de clôture des cas avant et après la mise en œuvre du triage par IA, ou surveiller la précision des urgences attribuées par l'IA par rapport aux corrections humaines.

Implémentation dans NetSuite : Exemple de Flux de Travail

Pour tout mettre en œuvre, nous décrivons un flux de travail conceptuel SuiteScript pour le triage automatisé :

-

Déclencheur : Un événement utilisateur (User-Event) ou une règle de flux de travail (Workflow Rule) se déclenche lorsqu'un nouveau cas de support (enregistrement

supportcase) est créé ou mis à jour (en particulier lorsque le statut = « Nouveau »). -

Collecte de Données : Le script lit les champs clés du cas. Il peut également effectuer une requête SuiteQL ou

search.loadpour trouver des données connexes. Par exemple :- Rechercher les cas ouverts du même Client pour récupérer les descriptions de problèmes récents.

- Récupérer la priorité/SLA du client à partir de l'enregistrement Client.

- Rechercher les pièces jointes ou messages liés à ce cas pour un contexte supplémentaire.

-

Prétraitement : Concaténer le texte extrait dans une invite structurée (prompt). Exemple d'assemblage de l'invite :

"Customer Name: " + case.customerName + "\n" + "Customer Tier: " + case.customField_tier + "\n" + "Case Title: " + case.title + "\n" + "Description: " + case.description + "\n" + "Based on the above information and similar past cases (if any), rate the urgency from 1 (lowest) to 10 (highest), and explain."Si vous utilisez RAG, incluez une étape telle que :

llm.createDocument({ title: "Past Case #X", text: pastCaseDescription(X) });pour plusieurs des cas passés les plus pertinents trouvés à l'étape 2.

-

Appel LLM : Invoquer l'API N/LLM :

- Soit

llm.generateText({ prompt: prompt, modelParameters: {...} }), soit, mieux,llm.evaluatePromptavec un schéma JSON attendant un champ entierurgencyScore. - Exemple :

const resp = llm.evaluatePrompt({ prompt: promptString, responseType: llm.ResponseType.JSON, schema: { type: 'object', properties: { urgencyScore: { type: 'integer' }, justification: { type: 'string' } } } }); const aiScore = resp.data.urgencyScore;

- Soit

-

Post-traitement : Le script reçoit le score numérique. Il peut le normaliser ou le regrouper (par exemple, 1–3 = Faible, 4–6 = Moyen, 7–10 = Élevé) ou le laisser tel quel. Il écrit ensuite ce score dans un champ personnalisé de l'enregistrement du cas (par exemple,

custcase_aiurgencyscore = aiScore), et enregistre éventuellement le texte de justification dans une note de cas pour l'audit. Si un seuil est dépassé, il peut également déclencher des alertes ou des mises à jour (par exemple, définir le champ de priorité du cas ou envoyer un e-mail au responsable). -

Humain dans la Boucle (Human-in-the-Loop) : Facultativement, si l'organisation est prudente, le score proposé par l'IA peut être une suggestion nécessitant l'approbation d'un responsable. Les flux de travail NetSuite peuvent être configurés pour attribuer les cas avec un score très élevé à la file d'attente d'un responsable pour examen.

-

Capture de Rétroaction : Lors de la clôture du cas (statut = Résolu/Fermé), un autre script peut comparer le score d'urgence de l'IA au temps de résolution final ou à la priorité réelle utilisée. Les écarts peuvent être enregistrés pour la surveillance des performances ou un affinage ultérieur.

Exemples de Code Clés

Vous trouverez ci-dessous un extrait de pseudo-code illustrant les étapes 3 à 5 :

define(['N/record','N/search','N/llm'], function(record, search, llm) {

function onSubmit(context) {

var caseRec = context.newRecord;

var title = caseRec.getValue('title');

var desc = caseRec.getValue('messagedetails');

var custId = caseRec.getValue('company');

var custRec = record.load({ type:'customer', id: custId });

var tier = custRec.getValue('custentity_customer_tier'); // e.g. Gold/Silver

// Gather similar past cases (SuiteQL or search):

var pastCases = search.create({ type:'supportcase', filters:[

['company','anyof',custId], 'AND',

['status','noneof','Closed'] // example filter

], columns:['internalid','messagedetails'] });

var simDocs = [];

pastCases.run().each(function(res) {

simDocs.push(res.getValue('internalid');

if(simDocs.length >= 3) return false;

return true;

});

// Attach their descriptions as documents for RAG

simDocs.forEach(function(caseId) {

var pastDetails = record.load({type:'supportcase', id: caseId}).getValue('messagedetails');

llm.createDocument({ title: 'Past Case ' + caseId, text: pastDetails });

});

// Build prompt

var promptText = "Customer Tier: " + tier

+ "\nCase Title: " + title

+ "\nCase Description: " + desc

+ "\nRate case urgency 1-10 and explain.";

// Call LLM

var result = llm.evaluatePrompt({

prompt: promptText,

responseType: llm.ResponseType.JSON,

schema: {

type: 'object',

properties: { urgencyScore: { type: 'integer' }, reasoning: { type: 'string' } }

},

modelParameters: { maxTokens: 50, temperature: 0.0 }

});

var score = result.data.urgencyScore;

// Write score to case

record.submitFields({ type:'supportcase', id: caseRec.id, values: {

custevent_ai_urgencyscore: score

}});

}

return { beforeSubmit: onSubmit };

});

Exemple 1 : Pseudo-code SuiteScript (2.1) pour l'attribution de scores d'urgence par IA. Ce script se déclenche lors de la création/mise à jour d'un cas, récupère les détails du cas et les cas passés similaires, les transmet au module N/LLM et réécrit un score généré par l'IA. (Adapté d'exemples de scripts N/LLM et d'exemples de développeurs NetSuite.)

Cet exemple montre à quel point il est relativement simple d'intégrer un appel LLM. Avec llm.createDocument, l'historique des cas passés est inclus (récupération). L'evaluatePrompt avec schéma JSON force un entier urgencyScore propre comme sortie. Le résultat met ensuite à jour l'enregistrement du cas. En réalité, une gestion des erreurs supplémentaire (par exemple, au cas où le service LLM ne serait pas disponible) et une gouvernance (par exemple, la journalisation de l'utilisation de l'API) seraient ajoutées.

Discussion : Défis, Implications et Orientations Futures

Précision, Confiance et Surveillance Humaine

Une préoccupation essentielle dans tout système de triage par IA est la précision et les biais. Même avec des performances moyennes élevées, les erreurs de classification peuvent avoir un impact grave (par exemple, une mauvaise priorisation d'une panne critique). Par conséquent, les organisations ne devraient pas automatiser entièrement les décisions de priorité sans surveillance. Les déploiements initiaux de ces systèmes impliquent souvent une revue par un humain dans la boucle (human-in-the-loop) : par exemple, la configuration de notifications Slack pour tout cas que l'IA marque comme « critique », afin qu'un responsable le vérifie. Au fil du temps, à mesure que la confiance augmente (par exemple, grâce aux données d'historique), on peut augmenter les seuils de confiance. L'inclusion de la justification du modèle (via une note SuiteScript) aide les humains à auditer les décisions de l'IA. C'est l'approche recommandée par de nombreuses pratiques d'IA en entreprise.

Il existe également des préoccupations concernant la confidentialité des données. Les tickets de support peuvent contenir des informations client sensibles. La pile d'Oracle traite vraisemblablement les requêtes LLM de manière sécurisée (le communiqué de presse indique que les données peuvent être traitées globalement conformément à la politique de confidentialité d'Oracle [44]), mais les entreprises pourraient avoir besoin d'assainir les informations personnelles identifiables (PII) avant de les envoyer au LLM. De plus, si les embeddings ou le contexte de l'invite incluent des connaissances propriétaires (par exemple, des détails d'architecture), il faut veiller à ne pas les divulguer par inadvertance via les API orientées LLM. L'utilisation par NetSuite d'un LLM basé sur le cloud signifie que les données transitent vers un point de terminaison Cohere/OCI. Les clients doivent évaluer les risques et éventuellement chiffrer ou tokeniser les données sensibles si nécessaire.

Impacts sur l'Intégration et les Flux de Travail

La mise en œuvre d'un score d'urgence par IA affecte les flux de travail de support. Du côté positif, cela peut avoir un impact considérable sur la vitesse de prise de décision. Les agents passent moins de temps à lire les tickets pour évaluer la priorité ; l'IA effectue l'analyse initiale. Cela leur permet de se lancer plus rapidement dans la résolution des cas, comme en témoignent les améliorations de la vitesse de résolution citées [9] [11]. Cela améliore également la cohérence : chaque ticket est évalué selon les mêmes critères (la logique apprise du modèle), évitant la variation humaine.

Cependant, cela nécessite également des changements. Par exemple, les agents de support client peuvent être sceptiques à l'égard de l'IA. Une formation et une transparence appropriées sont nécessaires : suivre la précision, autoriser les remplacements et communiquer que l'IA est un outil, et non un oracle infaillible. L'intégration exige également que les administrateurs maintiennent le système de notation (surveiller les quotas, mettre à jour les invites/modèles) à mesure que les conditions changent. La dérive des données (nouvelles versions de produits, nouveaux types de tickets) pourrait dégrader les performances au fil du temps. Le système doit être examiné périodiquement – par exemple, une analyse trimestrielle de l'IA par rapport aux données réelles – pour être recyclé ou ajusté.

De plus, la manière dont les métriques sont gérées pourrait changer. Traditionnellement, les équipes de support mesurent le temps de première réponse ou les temps de latence pour les priorités. Avec l'IA, de nouvelles métriques pourraient être introduites : précision du triage par IA (à quelle fréquence le score de l'IA correspondait à celui du superviseur humain), ou pourcentage de tickets ayant reçu une première réponse basée sur les suggestions de l'IA. Certaines entreprises pourraient suivre le retour sur investissement (ROI) : quantifier que « grâce au triage par IA, l'équipe a résolu X % de tickets de plus par mois » ou « a économisé Y heures de temps d'agent par semaine ».

Sur le plan informatique, l'utilisation de N/LLM à grande échelle engendre des coûts. Chaque appel LLM consomme des crédits/quotas. Bien que les petites invites pour le triage soient courtes, un centre de support très sollicité pourrait effectuer des milliers d'appels de triage par jour. NetSuite offre une certaine utilisation gratuite (free-tier) [26], mais au-delà, les clients paieront par jeton (token). Il est important de surveiller et éventuellement de regrouper les appels ou d'utiliser des modèles plus légers (les modèles d'embedding sont moins chers, par exemple). La mise en cache peut aider : par exemple, si de nombreux tickets ont un texte identique (par exemple, des demandes de FAQ), le score de l'IA peut être réutilisé à partir d'un texte identique précédent pour éviter de rappeler l'API.

Comparaisons et Analyse Multi-Perspective

Nous avons principalement discuté d'une voie d'implémentation (NetSuite + LLM). Comparons brièvement avec d'autres approches et considérons des perspectives plus larges :

-

Outils d'IA Tiers vs Boucle Fermée au sein de NetSuite : Certaines organisations peuvent utiliser des services de triage externes (par exemple, des fournisseurs d'IA spécialisés pour les centres d'assistance) qui s'intègrent à NetSuite via une API. Cela peut fournir des analyses avancées sans développement interne. Le compromis concerne le partage et le contrôle des données. L'approche de NetSuite (SuiteScript + N/LLM) maintient les données au sein de l'entreprise, ce qui peut être un avantage pour la sécurité et la conformité.

-

Modèles d'Apprentissage Automatique Simples : Une approche moins technologique consiste à former un modèle ML classique (par exemple, via le ML interne d'Oracle ou DataCloud, ou une plateforme externe) sur des exportations CSV de tickets historiques. Ce modèle pourrait prédire l'urgence et réécrire dans NetSuite via des appels API. Bien que plus simple et potentiellement moins cher par appel, il manque la flexibilité du LLM (pas de raisonnement ou de justification en langage naturel).

-

Perspective de l'Expérience Utilisateur : Un score d'urgence IA pourrait être affiché dans l'interface utilisateur de NetSuite (sous forme de champ, de code couleur ou de graphique). Une conception UX soignée est nécessaire pour que les agents voient le score comme un guide. La collaboration humain-LLM doit sembler naturelle : par exemple, les agents peuvent cliquer sur « Expliquer » pour voir le raisonnement de l'IA, ou relancer l'invite si nécessaire.

-

Dimensions Éthiques et d'Équité : Si les cas NetSuite impliquent le secteur public ou des industries réglementées, l'équité est une préoccupation. Une IA pourrait-elle par inadvertance prioriser certains clients ? Par exemple, si les données historiques présentaient des temps de réponse biaisés, le modèle pourrait les perpétuer. Il est judicieux d'auditer périodiquement ces biais. L'avantage d'un LLM à cet égard est que, s'il est invité correctement (« Considérez tous les utilisateurs de manière égale... »), il pourrait aider à neutraliser certains biais, bien que cela ne soit pas garanti.

Orientations Futures

Pour l'avenir, la technologie et le contexte commercial évolueront :

-

Modèles Améliorés : Les LLM sous-jacents eux-mêmes continueront de s'améliorer (par exemple, GPT-5, améliorations de Bard, etc.). Le N/LLM de NetSuite pourra les exploiter dès qu'ils seront disponibles. Les nouveaux modèles dotés d'une meilleure compréhension fine ou de filtres de sécurité intégrés rendront les scores d'IA plus fiables.

-

Apprentissage Adaptatif : Les fonctionnalités futures pourraient inclure un affinage (fine-tuning) intégré. Oracle ou ses partenaires pourraient proposer un réglage automatique du LLM sur les propres données de cas d'une entreprise, réinjectant l'apprentissage dans l'API NetSuite.

-

ChatOps et Agents : Nous pourrions voir des robots conversationnels au sein de NetSuite, où un agent peut discuter avec le système (« Quelle est l'urgence du cas 1001 ? ») et obtenir une réponse immédiate. Ceci est suggéré par des fonctionnalités telles que l'Assistant Chat IA de NetSuite dans CPQ [44], bien que cela ne soit pas directement lié au support pour l'instant. Cependant, étendre le chat aux scénarios de support est une étape logique (un agent pourrait interroger l'IA sur un cas délicat).

-

Triage Transversal : Dans de nombreuses organisations, le support couvre plusieurs domaines (IT, installations, RH). NetSuite pourrait potentiellement consommer des tickets RH ou de maintenance de manière similaire. Les aspects multicanaux (e-mail, portail, in-app) et multi-départementaux guideront les stratégies de triage intégrées, fusionnant éventuellement des données provenant de différents modules (support CRM, service sur le terrain, alertes de la chaîne d'approvisionnement).

-

Cas Proactifs et Maintenance Prédictive : Une fois la notation d'urgence en place, l'analyse peut identifier des modèles. Si certaines catégories de tickets deviennent fréquemment très urgentes, les administrateurs NetSuite pourraient s'attaquer de manière proactive aux causes profondes (par exemple, planifier la maintenance avant qu'une panne ne survienne). En d'autres termes, les données de triage par IA peuvent alimenter une gestion de la qualité des services plus large.

Conclusions

Ce rapport a examiné les dimensions théoriques et pratiques de la construction d'un système de notation d'urgence basé sur l'IA pour le triage des cas de support dans NetSuite. Les principales conclusions et recommandations sont :

-

La Nouvelle Infrastructure IA de NetSuite : Les API N/LLM SuiteScript facilitent techniquement l'intégration des capacités LLM dans les flux de travail de triage de support [3] [12]. Grâce à des fonctionnalités telles que la génération augmentée par récupération (retrieval-augmented generation) et les embeddings, les développeurs NetSuite peuvent élaborer des invites sophistiquées qui exploitent les données spécifiques à l'entreprise [23] [13].

-